Das Team von Mozilla, das vor allem für den Webbrowser Mozilla Firefox bekannt ist, hat eine umfassende Studie zu YouTube und seinen Algorithmen durchgeführt. Dabei wurden innerhalb eines Zeitraums von zehn Monaten Daten von 37.380 freiwilligen YouTube-Nutzern aus 190 Ländern mittels einer kleinen Browser-Erweiterung namens RegretsReporter gesammelt, die nun ausgewertet und präsentiert worden sind.

„2019 sammelte Mozilla unzählige Berichte von Menschen, deren Leben sich durch den Empfehlungsalgorithmus von YouTube verändert hat. Nutzern wurden Fehlinformationen präsentiert, entwickelten eine ungesunde Körperwahrnehmung und wurden auf bizarre Abwege gebracht. Je mehr Berichte wir lasen, desto deutlicher wurde uns bewusst, welch eine zentrale Rolle YouTube inzwischen im Leben so vieler Menschen spielt – und wie sehr sich die Empfehlungen von YouTube auf ihr Wohlergehen auswirken können. Doch wenn YouTube mit diesen Auswirkungen seines Empfehlungsalgorithmus konfrontiert wird, reagiert das Unternehmen jedes Mal ausweichend und leugnet den Sachverhalt.“

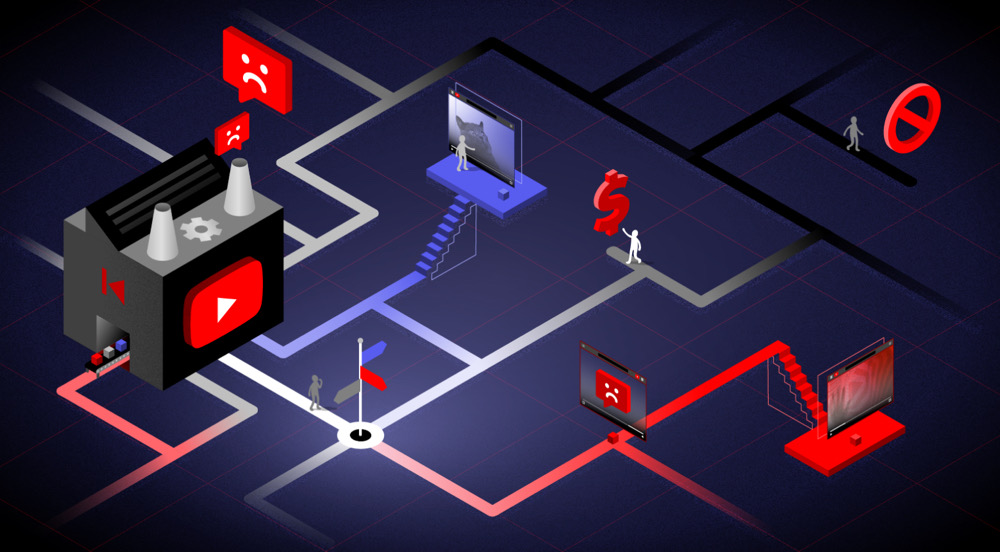

So berichtet Mozilla über die Hintergründe der nun erfolgten Studie. Googles YouTube-Algorithmus, der Nutzern und Nutzerinnen auf der Startseite basierend auf bisherigem Nutzungsverhalten entsprechende Video-Empfehlungen ausgibt, war in der Vergangenheit häufiger in die Kritik geraten. „Wir wissen, dass YouTube Videos empfiehlt, die gegen die eigenen Content-Richtlinien des Unternehmens verstoßen und Menschen auf der ganzen Welt schaden. Das muss ein Ende haben“, erklärt Mozilla.

Die Ergebnisse der Studie sind aufschlussreich, aber gleichzeitig auch erschreckend. Besonders YouTube-Nutzer und -Nutzerinnen, die nicht aus dem englischsprachigen Raum stammen, würden von den Vorschlägen der YouTube-KI benachteiligt. Die wichtigsten Erkenntnisse der Mozilla-Studie waren:

- Freiwillige Forscher stießen auf eine Reihe unpassender Videos, die alles von COVID-Angstmacherei über politische Fehlinformationen bis hin zu höchst unangemessenen „Kinder“-Cartoons berichteten.

- Die nicht-englischsprachige Welt ist am stärksten betroffen, wobei die Rate der unpassenden Videos in Ländern, in denen Englisch nicht die Hauptsprache ist, um 60% höher ist.

- 71% aller Videos, die von Freiwilligen als unpassend gemeldet wurden, wurden vom YouTube-eigenen Algorithmus aktiv empfohlen.

- Fast 200 Videos, die der YouTube-Algorithmus den Freiwilligen empfohlen hat, wurden inzwischen von YouTube entfernt – darunter auch einige, die nach Ansicht von YouTube gegen die eigenen Richtlinien verstoßen. Diese Videos hatten zusammen 160 Millionen Aufrufe, bevor sie entfernt wurden.

Mozilla hofft, mit diesen Erkenntnissen zu mehr Bewusstsein für derartige Vorschläge eines künstlichen Algorithmus beitragen zu können. „Mozilla hofft, dass diese Erkenntnisse – die nur die Spitze des Eisbergs sind – die Öffentlichkeit und den Gesetzgeber von der dringenden Notwendigkeit einer besseren Transparenz der KI von YouTube überzeugen werden“, erklärt Brandi Geurkink, Senior Manager of Advocacy bei Mozilla. „Es müssen dringend Maßnahmen ergriffen werden, um den Algorithmus von YouTube zu regulieren“, heißt es im deutschen Bericht zur Studie. Die weiteren Erkenntnisse können in englischer Sprache hier im vollständigen PDF-Bericht nachgelesen werden.