Apple hat in der vergangenen Woche mit der Ankündigung von geplanten Sicherheitsmechanismen für Kinder in iOS 15 für Furore unter Nutzern und Nutzerinnen gesorgt. Obwohl die zugrunde liegende Absicht natürlich lobenswert ist – dem Schutz von Kindern und Jugendlichen vor sexueller Ausbeutung und Konfrontation mit kinderpornografischem Material – sorgten die präsentierten Features für große Skepsis.

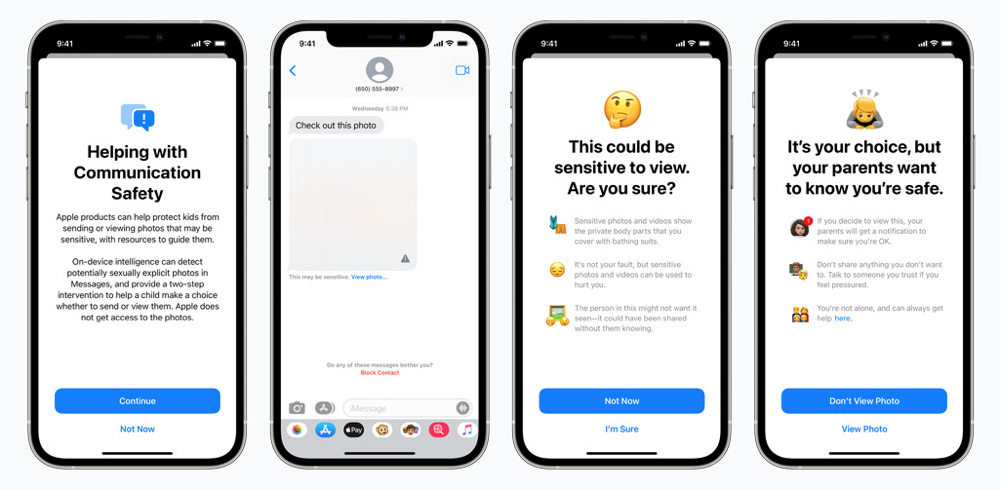

Apple möchte mit iOS 15 nämlich nicht nur den Zugang zu Hilfestellungen beim Melden von sexuellem Kindesmissbrauch und der Ausbeutung von Kindern über die Sprachassistentin Siri und die Websuche vereinfachen, sondern plant auch, in iMessage Bildanhänge zu analysieren, die sexuell anstößiges Material enthalten, um dann entsprechende Warnungen auszugeben. Vor allem aber das angekündigte Scannen von Fotos in der iCloud, der Abgleich mit bekanntem Bildmaterial von sexuellem Kindesmissbrauch und der Meldung an entsprechende Organisationen sorgte für Bedenken.

In einem Interview mit dem Magazin TechCrunch hat nun Apples Leiter für Datenschutz, Erik Neuenschwander, weitere Fragen zu diesem Thema beantwortet. Er wurde beispielsweise gefragt, ob Apple mit den geplanten Funktionen auch Regierungen und Agenturen auf der ganzen Welt demonstrieren möchte, dass es gleichzeitig möglich sei, nach expliziten Inhalten zu scannen, aber auch die Privatsphäre der Nutzer und Nutzerinnen zu bewahren.

„Der Grund dafür ist, wie Sie bereits sagten, dass dies eine Erkennungsfunktion ist, die die Privatsphäre der Nutzer schützt. Wir sind motiviert durch die Notwendigkeit, mehr für die Sicherheit von Kindern im gesamten digitalen Ökosystem zu tun, und ich denke, alle drei unserer Funktionen sind sehr positive Schritte in diese Richtung. Gleichzeitig werden wir die Privatsphäre aller Personen, die nicht an illegalen Aktivitäten beteiligt sind, nicht beeinträchtigen.“

TechCrunch fragte Neuenschwander auch, ob Apple einen Rahmen geschaffen hat, der von Strafverfolgungsbehörden genutzt werden könnte, um nach anderen Arten von Inhalten in den Bibliotheken der Nutzer zu suchen, und ob dies Apples Engagement für eine End-to-End-Verschlüsselung untergräbt.

„Das Gerät ist immer noch verschlüsselt, wir haben den Schlüssel nicht, und das System ist so konzipiert, dass es mit den Daten auf dem Gerät funktioniert. Was wir entworfen haben, hat eine geräteseitige Komponente – und es hat übrigens die geräteseitige Komponente, um den Datenschutz zu verbessern. Die Alternative, die Daten der Nutzer auf einem Server zu verarbeiten und auszuwerten, ist anfälliger für Änderungen [ohne Wissen der Nutzer] und schützt die Privatsphäre der Nutzer weniger.“

Auch im Hinblick auf Schutzmaßnahmen im System wurden von TechCrunch kritische Fragen gestellt. Man stelle sich vor, örtliches Recht und Regierungen, beispielsweise in China, würde es Apple nur erlauben, den Mechanismus im jeweiligen Land zu verwenden, wenn auch nach anderem Material gesucht werden dürfte. Erik Neuenschwander erklärt dazu:

„Die Hash-Liste ist in das Betriebssystem integriert. Wir haben ein globales Betriebssystem und keine Möglichkeit, Aktualisierungen auf einzelne Nutzer auszurichten, so dass die Hash-Listen von allen Nutzern gemeinsam genutzt werden, wenn das System aktiviert ist. Zweitens erfordert das System, dass der Schwellenwert für die Anzahl der Bilder überschritten wird, so dass der Versuch, auch nur ein einziges Bild von einem Gerät einer Person oder einer Gruppe von Geräten einer Person zu finden, nicht funktionieren wird, weil das System Apple einfach keine Informationen über einzelne Fotos liefert, die in unserem Dienst gespeichert sind. Und drittens ist in das System eine Phase der manuellen Überprüfung eingebaut, in der, wenn ein Konto mit einer Sammlung von illegalem CSAM-Material gekennzeichnet wird, ein Apple-Team dies überprüft, um sicherzustellen, dass es sich um illegales CSAM-Material handelt, bevor es eine Weiterleitung an eine externe Stelle vornimmt. Der hypothetische Fall erfordert also das Überspringen vieler Hürden, einschließlich der Änderung des internen Prozesses von Apple, um Material weiterzuleiten, das nicht illegal ist, wie bekannte CSAM. Wir glauben nicht, dass es eine Grundlage gibt, auf der die Menschen in den USA einen solchen Antrag stellen können.“

Sich den neuen Sicherheitsmechanismen zu verweigern, sei laut Neuenschwander möglich, wenn iCloud Fotos nicht verwendet würde. „Und der letzte Punkt, den ich noch hinzufügen möchte, ist, dass die Wahlfreiheit des Nutzers erhalten bleibt: Wenn ein Nutzer diese Art von Funktionalität nicht mag, kann er wählen, iCloud Photos nicht zu nutzen, und wenn iCloud Photos nicht aktiviert ist, ist kein Teil des Systems funktionsfähig.“

Apples Datenschutz-Chef erklärte im Interview außerdem, dass Apple bei Nutzern, die „nicht an diesem illegalen Verhalten interessiert sind, kein zusätzliches Wissen über die Cloud-Bibliothek eines Nutzers erlangt“ und dass „die Privatsphäre völlig ungestört bleibt“.

Die alleinige Lösung, diesen mit iOS 15 geplanten Maßnahmen zu entgehen, scheint laut Apple nur die Option zu sein, iCloud Fotos komplett zu deaktivieren. Wirklich kundenfreundlich wirkt diese Aussage leider nicht, zumal auch der Großteil der Nutzer und Nutzerinnen diesen geplanten Sicherheitsoptionen zustimmen muss, der keinerlei verdächtiges Material auf ihren Geräten speichert. Es bleibt abzuwarten, ob diese neuen Sicherheitsmaßnahmen auch mit europäischen Datenschutzgesetzen konform gehen. Unseren Artikel zu den neuen Sicherheitsoptionen könnt ihr hier nochmals nachlesen.

Also erst mal nicht auf iOS 15 updaten….

Ich glaube nicht, dass eine wie auch immer tolle Firma staatliche Aufgaben übernehmen sollte.

Also wenn das kommt, nie wieder iPhone!!! Kind im Urlaub beim Baden fotografiert -> Knast. Noch nicht 18 und Freund ein freizügiges Foto geschickt -> Knast. Nein danke Apple.

So ein Schwachsinn… Glaubst das wirklich, was du schreibst? :-S

nur zur Info. Des machen übrigens die meisten Cloud Anbieter schon seit Jahren. Neu ist dies definitiv nicht. Es ist nur neu, dass die Daten lokal gescannt werden bzw. vor dem Uploud in die iCloud.

Sie haben also Zugriff. Sie können die Fotos ‚händisch’ analysieren. Niemand weiß, was die alles wirkl. als illegal werten. Ind wie dreist: wer nichts zu verbergen hat, für den ist es ja problemlos, wenn wir schnüffeln. Wie Google, absolut ekelhaft!

Dann fotografiert man halt seine Kinder NICHT nackt am Strand und lässt die Bilder dann in eine Cloud hochladen… Ich verstehe diese ganze Diskussion nicht. Ich habe selber zwei Kinder, ich käme gar nicht auf die Idee solche Bilder zu machen.

Keine Fotos machen? In unserem Garten benötigen unsere Kinder keine Kleidung. Nur Hühner die gaffen. Und deswegen darf ich nun keine schönen Fotos mehr machen.

Am Strand würde ich nie einer meiner Töchter nackt rum laufen lassen. Zu viele Menschen. Obwohl ich also darauf achten, habe ich nun dennoch das Problem, welches kommen wird.

Außerdem: wer seine Kinder nackt auf dem Strand rum laufen lässt, hat doch eh schon alles falsch gemacht. Da ist die cloud das geringste Problem…..

Apple wird für den Abgleich der Fotos sogenannte Perceptual (wahrnehmbare) Hashes verwenden. Das sind keine Hashes im klassischen Sinn, sondern das Bild wird hierfür auf bestimmte Weise in Bereiche aufgeteilt, in Graustufe konvertiert und dann die Helligkeit der einzelnen Pixel verglichen. Es gibt jedoch mehrere Verfahren, die teilweise sehr komplex sein können. Im Vergleich zu klassischen Hashes führen kleine Änderungen am Bild nicht zu einem vollkommen anderen Hash-Wert. Bei Perceptual Hashes gibt es Annäherungswerte, die angeben, wie weit sich das Bild vom Ursprungsmaterial unterscheidet. So funktioniert zum Beispiel auch die Musikerkennung bei Shazam. Der Song mit dem höchsten Annäherungswert wird am Ende als Song „erkannt“.

Apple kann und wird mit dem Annäherungswert spielen um die Rate von false-positives (also falsch positiv) erkannten Bildern zu beeinflussen. Hieraus ergibt sich schon, dass Apple ein gesundes Mittelmaß zwischen falsch-positiv erkannten Bildern und jenen finden muss, die vom Ursprungsmaterial modifiziert wurden.

Dadurch ergeben sich natürlich einige Fragen. Woher bekommt Apple die Hashes der Bilder? Auf welche Weise wurden die Hashes berechnet? Wie geht man mit falsch-positiven Ergebnissen um? Zumindest auf die letzte Frage ist Apple eingegangen: Mitarbeiter überprüfen solche Bilder manuell!

Auch jetzt schon benutzt Apple die o.g. Technik zu Erkennung von Mustern in Bildern, aus diesem Grund kann man nach bestimmten Begriffen suchen: Berge, Eifelturm, Seen, usw.

Google nutzt diese Technik auch um bei YouTube während des Uploads zu erkennen, ob urheberrechtlich geschützte Musik verwendet wurde.

Komisch ist, dass Apple nicht die WWDC genutzt hat um die Hintergründe näher zu erläutern, sondern per Pressemitteilung die Funktion ankündigt und anschließend um Erklärung bemüht ist.

Für mein Verständnis: die Mitarbeiter prüfen manuell, ob das Bild tatsächlich ein solcher Fall ist? Habe ich also Gartenpool-Fotos meiner Tochter in der Foto cloud von Apple, werden die nackt-Bilder von echten Menschen durch geschaut?

Möchtest du es wirklich nicht verstehen? Es hat doch mit den von dir erstellten Bilder überhaupt nichts zu tun! Es geht darum, dass einschlägig bekannte Bilder(!) analysiert werden und daraus eine eindeutige Prüfsumme erstellt wird. Diese Summe wird gesucht. Falls dein privates Bild diese Summe hat, dann wurden dir vorher die Bilder gestohlen (oder du hast sie absichtlich) in irgendwelche verbotenen Foren hochgeladen oder in irgendeiner Form anderen zugänglich gemacht. Ganz nebenbei handelt es bei diesen Aufnahmen vermutlich auch nicht um Bilder, die nackte Kinder am Strand oder im Garten zeigen…

Das Problem ist, dass die Prüfsumme eben nicht eindeutig ist, sonst würde Apple schon solche Bilder nicht mehr finden, die nur um einen Pixel skaliert wurden. Es werden optische Merkmale berücksichtigt. Und diese können, bei stark vorhandener Ähnlichkeit, tatsächlich ein falsch-positives Ergebnis auslösen. Es ist aber unwahrscheinlich, dass sich mehrere Bilder ähneln, wenn Apple also erst bei mindestens zwei „Treffern“ aktiv wird, gebe ich zu, ist es schon sehr unwahrscheinlich das man durch ein selbst aufgenommenes Foto betroffen sein wird.

Wieso sollte ich fragen, wenn ich es nicht verstehen möchte? Ich ging nicht davon aus, dass exakt nach diesen Fotos gesucht wird, die schon vorhanden sind. Ich dachte, es werden weitere Fotos gesucht, die ebenfalls die vagina eines Kleinkindes zeigen zb. So dachte ich. Und da man schlecht nun Fotos nur dafür machen sollte, werden eben die aus der Datenbank genommen. Und da ich das so dachte (was ja zum Wohle des Kindes eigentlich gut wäre), ergab sich eben so meine Frage.

Und ansonsten danke für die weitere Erklärung 🙂

Bei falsch-positiven Ergebnissen ist dies durchaus möglich, ja. Aus genau diesem Grund üben Datenschützer auch Kritik. Abgesehen davon, dass man diese Technik auch missbrauchen könnte um bspw. nach politisch verbotenem Material zu suchen, was für Länder wie China sicherlich nicht uninteressant wäre. Aber siehe auch meine Antwort an mark, je nachdem wie Apple den Abgleich implementiert hat, ist es nicht sehr wahrscheinlich, dass ein einziges Nacktfoto deiner Freundin oder deiner Tochter bereits dazu führt, dass ein Mitarbeiter von Apple das Foto überprüft.

„Das Gerät ist immer noch verschlüsselt, wir haben den Schlüssel nicht, und das System ist so konzipiert, dass es mit den Daten auf dem Gerät funktioniert. Was wir entworfen haben, hat eine geräteseitige Komponente – und es hat übrigens die geräteseitige Komponente, um den Datenschutz zu verbessern.“

Wenn das so ist, warum funktioniert dann diese neue Analysefunktion nur bei aktiviertem „iCloud Photos“?

Wenn das so ist, warum funktioniert dann diese neue Analysefunktion nur bei aktiviertem „iCloud Photos“?

Vielleicht, weil auf dem Gerät Foto für Foto in der iCloud geprüft wird? Wenn die Prüfung im Betriebssystem verankert ist und nur lokal auf dem iPhone geschieht, dann muss jedes Element so geprüft werden.

Ich frage mich nur, wie die Mitarbeiter das dann vor Ort in der „Feinprüfung“ machen. Schlussendlich muss dann ja einer doch die Daten entschlüsseln können, oder?

Wenn das so wäre – wer zahlt den Datentransfer? Der Kunde, dessen xGB-Flat plötzlich aufgebraucht ist?

@klenkes: Na, da steht doch, dass es gerade nicht in der iCloud ausgewertet wird, sondern lokal auf dem Gerät, eben durch „die geräteseitige Komponente“.

Dazu passt aber nicht, dass das nur gemacht wird, wenn man iCloud Photos aktiviert hat.

iCloud Fotos aktiviert die Möglichkeit/ den Befehl. Auf dem Gerät wird es ausgeführt, mit der Hardware, die dafür benötigt wird.

So stelle ich es mir vor.

Ich habe iCloud Fotos gar nicht aktiviert, da ich einen anderen Speicher für meine Fotos verwende. Insofern sehe ich der Funktion relativ gelassen entgegen.

@hurgl: Ich habe es auch nicht aktiviert, sehe es aber trotzdem nicht ganz so gelassen. Etwas passt an dieser Beschreibung nicht. Entweder es ist mal wieder „unglücklich formuliert“, oder es ist doch nicht so wie zunächst suggeriert „ausschließlich auf dem Gerät“, oder es ist nur der Anfang einer größeren Überwachungsfunktion, die später ausgeweitet wird.

Ach wie schön: Dann wird mein Gerät ab iOS 15 vom iPhone zum spyPhone aufgewertet. Ich kann’s garnicht erwarten bis Apple nach eigenen (und vor mir sorgsam verborgenen Kriterien) alle meine Bilder durchschnüffelt und bei Falsch-Positiven darf auch noch ein Apple-Mitarbeiter persönlich gucken. Denen wollte ich meine privaten Bilder schon immer mal zeigen und ich freue mich ausserordentlich für das Interesse. Schöne neue Welt.

Irgendwann sind alle Regierungsgegner Pedos wenn die iOS benutzen 😹

So Schutzen wir uns alle Danke.

Oder wie Julian Assange werden skrupulöse Vergewaltiger 😉