Am vergangenen Dienstag wurden die ersten Testberichte des iPhone XR veröffentlicht, das ab Freitag ausgeliefert und in Apple Stores verfügbar sein wird. Abgesehen vom Display kann das neue iPhone XR durchaus mit dem iPhone XS mithalten, in einer Disziplin ist es dem Flaggschiff sogar deutlich überlegen: Portrait-Fotografien bei schlechten Lichtverhältnissen.

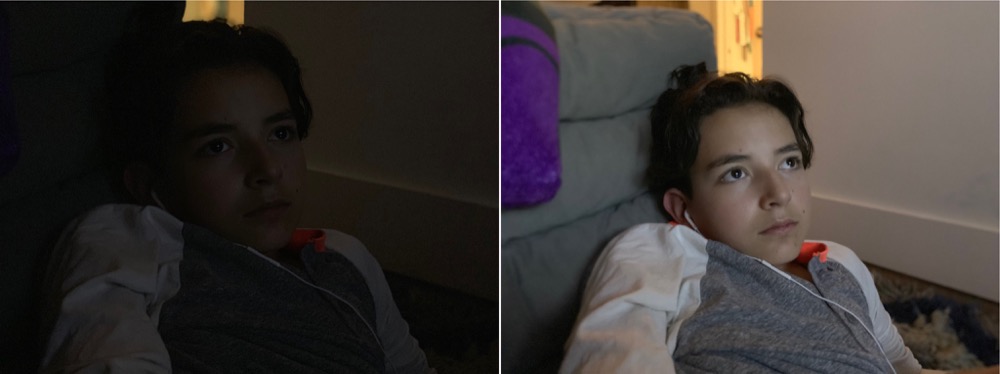

Dieses Phänomen hat unter anderem John Gruber entdeckt, der das neue iPhone XR bereits vorab ausprobieren durfte. Wirklich sehr gut sichtbar wird der Unterschied auf den folgenden beiden Bildern, die abgesehen von der Größenanpassung und der Konvertierung vom Format HEIC in JPG nicht bearbeitet wurden.

Wer zunächst daran denkt, dass das Portrait-Foto des iPhone XS auf der rechten Seite zu finden ist, der täuscht gewaltig. Obwohl das iPhone XR deutlich günstiger ist, macht es das viel bessere Foto.

Der Grund dafür ist schnell erklärt. Das iPhone XS verwendet für Portrait-Aufnahmen die Tele-Linse. Diese ist zwar von Haus aus besser für Bokeh-Effekt geeignet, hat allerdings einen großen Nachteil: Der Sensor ist nur halb so groß wie der Sensor der Hauptkamera.

Reicht Apple die Funktion auf dem iPhone XS nach?

Das iPhone XR hat keine eigene Tele-Linse und knipst die Fotos mit der Hauptkamera und eben einem größeren Sensor. Ein richtiger Bokeh-Effekt ist damit eigentlich nicht möglich, dieser wird nachträglich per Software berechnet. Dafür aber wird das Bild von dem deutlich größeren Sensor eingefangen, was sich bei wenig Licht anscheinend sehr deutlich bemerkbar macht.

Die Portrait-Funktion des iPhone XR basiert also nicht auf der Hardware, sondern auf der Software. Das gibt zumindest uns ein kleines bisschen Hoffnung, dass Apple es Besitzern eines iPhone XS bald erlauben wird, ebenfalls Portrait-Aufnahmen mit der Hauptkamera anzufertigen.

Dieser Unterschied ist schon wirklich sehr bemerkenswert. Ich kann mir nicht vorstellen, dass Apple diese bessere Bildqualität bei schlechten Lichtverhältnissen den XS-Nutzern vorenthalten wird. Es sollte wohl möglich sein, dass die KI dann die Kamera verwendet, die das bessere Ergebnis liefert. Oder noch besser, wenn auch unwahrscheinlich: Der User kann manuell zwischen den Kameras wechseln.

Siehe meinen Kommentar unten 🙂

Der Bokeh-Effekt beim iPhone X/Xs wird auch nur per Software errechnet.

Das ist sowieso alles ein riesen Unfug. Haltet doch einfach die zweite Kamera mal beim Fotografieren zu. Voila: trotzdem ein Bokeh Effekt…insofern ist es wohl eine Kleinigkeit diesen Effekt auf eine der beiden Linsen anzuwenden.

Das ist leider kein Unfug. Und der von dir beschriebene Trick funktioniert auch nicht. Halte ich bei meinem iPhone X die Weitwinkel-Linse zu, dann funktioniert auch der Bokeh-Effekt nicht.

In dem Artikel von John Gruber ist die Problematik sogar beschrieben, hier im Artikel leider nicht.

iPhones mit zwei Linsen können die Tiefe im Raum erkennen und daraus berechnet die Software den Effekt. Wenn es nur eine Linse gibt, kann man auch keine Tiefe erkennen. Daher funktioniert es hier über Gesichtserkennung. Geht also weder bei Tieren, noch bei Pflanzen etc.

Vermutlich hat Apple diese Restriktion daher eingebaut, damit man den Usern nicht erklären muss, dass der Effekt ab einer Gewissen Helligkeit nur noch mit Gesichtern funktioniert. Zudem ist Apple nicht dafür bekannt für jede mögliche Funktion irgendwo einen Schalter einzufügen. Das bekommt man eher bei anderen Herstellern 😉

@Sebastian: Danke für die gute Erklärung!

Die Bilder von daringfireball.net klauen, aber dann noch nicht mal drauf verlinken …

Eine Verlinkung zur Quelle fehlt hier leider in vielen Beiträgen 🙁

Dass der blaue Block unten nicht explizit als Werbung deklariert wird, ist auch unschön.

Danke für den Hinweis, beides richtig – und geändert.

Super! 🙂